-

확률론과 Bayesian Decision Rule(Inference Model)카테고리 없음 2020. 3. 15. 22:18

확률론에는 빈도론(Frequentism)과 베이지안(Bayesian)으로 크게 나눌 수 있으며, 머신러닝 모델 또한 이론에 입각하여 빈도론의 Generator model과 베이지안 룰에 따른 Inference model이 있다.

일반적으로 우리가 알고 있는 확률론은 Generator model이다. 발생한 값들을 보고 그 사건에 대한 값을 예측하는 것이다. 예를 들어보면, 동전을 10번 던졌을때, 앞면이 나올 확률이 50%이면, 100번 던졌을때, 앞면이 50%확률로 나온다고 예측하는 것을 말한다.

즉, 빈도론에서 확률은 '사건이 일어나는 장기적인 확률'로써 오로지 경험적 사실만을 통해 이야기할 수 있다는, 객관적인 입장을 취하며, 베이지안은 '지식이나 판단의 정도를 나타내는 수단'으로써, 주관적인 입장을 취할 수 있다.

하지만. 모든 사건을 경험에 입각하여 예측할 수 없다는 한계를 가지기 때문에, Bayesian Decision Rule이 활용된다.

예를 들어, 한번도 일어나지 않은 콘테스트에서 참석자가 몇명 올지 예측하려면, 여러 지식들을 동원해서 우승과 관련된 요소들을 뽑고, 이를 통해 확률을 도출하는 방법일 것입니다. 이러한 과정이 바로 베이즈 정리에 입각한 베이지안 추론입니다.

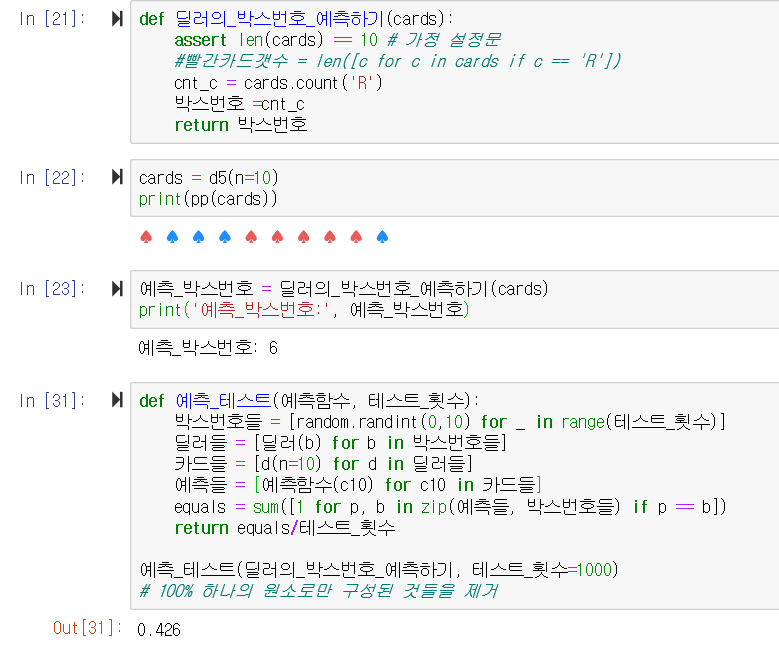

강의 시간에 활용된 예시로서 해당 코드를 따라가보자.

총 11개의 박스를 만들고 해당 박스는 파랑, 빨강 카드가 준비되어있다. 이후, 딜러가 카드를 뽑을 것이고 카드가 나오는 분포를 토대로 해당 박스를 예측할 것이다.

이후, 박스번호를 지정하여, 카드를 뽑아 볼 것이다. 처음에 박스에 따라 카드의 색깔 비율이 달랐기 때문에, 카드를 뽑을때, 박스에 따라 카드가 나오는 확률 분포가 다를 것이다.

가장 먼저 떠오르는 방식은 실제 박스의 카드 구성대로 예측모델을 구축하는 것이다. 0번은 파란 카드로 10번을 빨간 카드로만 가득하기 때문에, 정해진 카드가 나올 확률이 100%이고 그외의 박스들에서도 어떠한 카드가 많냐에 따라 해당 색깔을 카드가 나올 확률이 커진다.

따라서, 빨간 카드의 카운트 수를 토대로 해당 박스의 번호라고 예측모델을 구성했다. 이후, 예측_테스트에서 1000번의 테스트 결과 42.6%이 정확도를 가지는 것을 확인할 수 있다.

데이터를 토대로 박스의 번호를 예측하는 모델을 구성하는 것은 대단히 어렵다. 나름 합리적이라 판단했던 모델의 예측도 42.6%로 절반에 가깝다.

이번에는 예측 모델을 만들지 말고 한번 1000번의 데이터를 돌렸을때, 해당 박스에서 어떠한 카드 구성을 나타내는 지 한번 그래프로 그려보자.

박스의 번호가 커질 수록 중심값이 분포가 오른쪽으로 이동하는 것을 확인할 수 있으며, 색깔의 분포가 1:1인 5번 박스에 가까울 수록 분포가 고르게 퍼지며, 정규분포의 형태처럼 종모양을 보이고 있다.

이제부터는 해당 예시를 통해, Bayesian Decision Rules에 대해 설명해볼 것이다.

우리는 딜러가 뽑은 카드의 구성을 토대로 어떠한 박스에서 뽑은 카드들인지를 예측하고 싶었고 박스의 구성에 따라 'R', 빨강 카드의 카운트를 매겨 박스를 예측했다.

N번 카드를 뽑을 확률을 P(Z)이라 하고 뽑혀진 카드들 중에서 빨강 카드가 있을확률을 P(X)라 하면, 다음과 같다.

P(Z=3): 3번 박스를 뽑을 확률

P(X=3): 뽑힌 10개카드에서 레드카드가 3개 관측될 확률

P(Z=4) = 1/11

P(X=3) = 0번 박스일 때, 3개 나올 확률 => P(X=3 & Z=0)

1번 박스일 떄, 3개 나올 확률 => P(X=3 & Z=1)

~~~

10번 박스일 때, 3개 나올 확률 => P(X=3 & Z=10)바로 위에서 1-10번 박스에서 나오는 카드를 100000번 뽑아 분포를 그렸던 것은 P(X|Z)의 모델이라 할 수 있다. 박스의 번호를 지정하고 카드를 뽑아 빨강 카드가 나올 확률을 뽑았기 때문이다. P(X|Z) 모델을 Generator model이라고 한다.

주어진 사건, 경험한 사건 에서 해당 확률을 뽑아보는 것이다. 객관적인 방법이라 할 수 있다.

그렇다면, 위에서 42.6%로 카드를 보고 어떠한 박스에 있을지 본 것은 P(Z|X) 모델이며 Inference model이라 할 수 있다. 이것은 카드가 뽑혀진 확률 P(X)를 토대로 박스의 확률 P(Z)를 만드는 모델이기 때문이다.

이처럼 조건부에 걸리는 대상에 따라, 관측 값이 고정됐는지 혹은 유동적인지에 따라, AI 모델은 Inference model과 Generoator model로 나눌 수 있다. Generator model은 현재 게임이나 산업분야에서 많이 활용되고 있다. 하지만, Inference model은 난이도가 높다.

P(Z/X): inference는 해보지 않은 것을 예측해야하기 때문에 어렵고 P(X/z):simulation, Generator Likelihood는

관측된 것들을 토대로 가장 가능성(likelihood)가 높은 것을 뽑는 것이기 때문에, 상대적으로 쉽다.

따라서, P(Z|X)를 풀때, P(X|Z)를 활용하며, 이때 Bayesian rule이 적용된다. 이 법칙을 사용하면, 정해진 문제를 우리가 쉽게 풀어낼 수 있는 서브 문제로 나눠서 풀 수 있다.

P(Z|X)의 모델을 P(X|Z)를 통해 유추해내는 것을 Bayesian rule이라 한다.

P(Z|X) = P(X|Z) * P(Z) / P(X) : baisian rules

* X: 사진, Z: 라벨

VISION영역에서 AI모델은 다음 방법론을 통해 라벨 값을 맞춘다. 위의 예로 말하자면, black box인 어떠한 박스 번호인지를 맞출 수 있다.

요약하자면, 우리는 해당 사진이 어떠한 라벨에 걸리는 지를 알고 싶다. 하지만, 해당 모델은 P(Z|X), Inference model로서 너무나 어렵기 때문에, baisian rules을 활용하여 문데를 해결한다.

baisian rules 은 라벨에 대한 사진 값의 확률: P(X|Z) 을 구한 후, 이를 활용하여 P(Z|X)를 구해낸다.

여기서 인공지능 분류 모델의 한계점을 찾을 수 있을 것이다. 인턴 기간 동안 참여한 해당 반려동물 어플 또한 일부 사진을 강이지라고 잘 못 분류한다. 그 이유는 인공지능 모델이 데이터에 기반하여 만들어지기 때문이다. 학습데이터로서 라벨을 지정한뒤, '웃고있는 사진', '누운 사진' , '실내 사진' 등 라벨에 대한 데이터를 모으고 해당 라벨에 대한 사진의 확률값 P(A|B)를 토대로 P(B|A)를 유도하기 때문에, 데이터가 어떻게 생겼는 지에 따라 모델을 추론은 언제든지 달라질 수 있다. 따라서, 국가 마다 얼굴 인식 모델 등이 다를 수 있는 것이 라벨에 따른 데이터를 수집할때 서양인과 동양인의 특징점이 다를 수 있기 때문이다.

# 조건부 확률 및 Likelihood(우도)

- P(A) / P(A1), P(A2), P(A3)은 이미 알고 있는 정보, 알고있는 확률이라고 해서 사전확률(prior probability)라고 부릅니다. 사전확률은 현재 알고 있는 정보로 이해하면 된다.

- B(B|A) / P(B|A1), P(B|A2), P(B|A3)은 우도(likelihood)라고 부릅니다. likelihood는 조건부 확률인데 과거의 경험에 근거하여 관심 있는 사건이 일어날 가능성입니다. 또한, 해당 likelihood에서 가장 가능성이 높은 것을 Maximum Likelhood라 한다.

- 조건부 확률의 의의는 sample space를 줄이는 것에 있는데 여기서는 전체 sample space에서 "과거의 경험, 알고 있는 정보"로 scoping한 것입니다. 따라서, 이를 통해 우리는 다시한번 베이즈 정리의 의의에 대해서 생각해볼 수 있겠네요. "과거의 경험/정보로 부터 관심 있는 사건의 확률에 대해 추정한다."

- P(A|B)는 B라는 사건이 일어난 뒤에 그 것이 우리가 알고 있는 정보에 기인한 것인지를 알아보는 확률이라고 이해하면 되겠습니다. 이를 사후확률(posterior probability)라고 합니다.

참고자료:

1. https://untitledtblog.tistory.com/136

[머신 러닝] Bayesian Decision Theory

Bayesian decision theory는 통계 및 머신 러닝 분야에서 핵심적으로 이용되고 있는 방법론이다. Bayesian decision theory는 어떠한 decision problem이 확률적으로 표현이 가능하고, 해당 문제와 관련된 모든 확..

untitledtblog.tistory.com

2. https://sumniya.tistory.com/29

베이지안 추론(1) - 이론

개인적으로는 통계의 본질은 실제 세계의 문제를 확률분포로써 수학적으로 모델링하고, 가정한 분포의 parameter를─error를 컨트롤하면서 이를 최소화하며─추정하는 학문이라고 생각합니다. 따라서, 통계학에서..

sumniya.tistory.com